Il nostro rapporto con le AI è sempre più simile a una relazione intima. Una fusione che sta avvenendo in modo graduale, quasi naturale, e le cui conseguenze e rischi sono tutti da verificare.

Qualche tempo fa, ho deciso per la prima volta di sfruttare massicciamente ChatGPT per scrivere un articolo. L’obiettivo non era tanto quello di risparmiare qualche ora di lavoro (e infatti penso di averci messo più o meno lo stesso tempo), ma di testarne le potenzialità e interagire in maniera assidua con il large language model di OpenAI, per capire dove mi avrebbe portato il tentativo di instaurare con esso una vera e propria relazione professionale (solitamente lo utilizzo solo per qualche banale e rapido compito).

Ho allora chiesto a ChatGPT di eseguire, per iniziare, una “ricerca profonda” (usando l’apposita modalità Deep Research) sul tema del’articolo – ovvero le prospettive del 6G, la prossima generazione di trasmissione dati mobile – fornendo alla macchina indicazioni specifiche sugli aspetti che più mi interessavano (enti e società coinvolte, prospettive di mercato, brevetti, nazioni in corsa, caratteristiche, ecc.).

Ottenuti (e verificati) i risultati, gli ho poi chiesto di approfondirne alcuni, di trovare paper scientifici che analizzassero le caratteristiche tecniche, di cercare analisi relative agli ostacoli che la tecnologia 6G deve superare, di spiegarmi alcune dichiarazioni di esperti particolarmente impenetrabili o troppo vaghe. Dopo aver stilato una scaletta del mio articolo, gliel’ho sottoposta: chiedendo di darmi un giudizio, di suggerirmi cosa modificare, quali parti eliminare e cosa eventualmente integrare.

Durante il processo di scrittura , ho impiegato ChatGPT non solo per scovare refusi (come faccio ormai sempre), ma anche per aiutarmi a migliorare periodi che mi parevano incerti (ogni volta rileggendo e adattando il suo output, se non rifiutandolo completamente), per indicarmi quali passaggi fossero – secondo lui – involuti e come, per sistemarli, li avrebbe spezzati, se avesse modificato qualcosa nell’ordine dei vari argomenti e altro ancora.

Una volta finito, ho sottoposto a ChatGPT l’intero articolo in modo che potesse controllare un’ultima volta che i dati fossero esatti, che le mie valutazioni personali fossero condivisibili, che gli aspetti più tecnici fossero riportati correttamente. Ottenute le sue considerazioni sotto forma di (numerosi) punti, e poiché nel frattempo si era fatto tardi, ho concluso la conversazione dicendo a ChatGPT: “Grazie, ci guardo per bene domani”.

Perché avevo dato a una macchina una risposta del genere? In parte, era stato uno scherzo tra me e me. In parte, mi è venuto spontaneo. Dopo aver collaborato per ore a stretto contatto con un’intelligenza artificiale (usando inoltre solo il linguaggio naturale), mi sarebbe sembrato strano chiudere il dialogo così, all’improvviso, senza dire nulla.

La sua risposta mi ha fatto però anche più impressione: “Perfetto, fai pure con calma”. Un’intelligenza artificiale mi aveva appena dato il permesso, per così dire, di smettere di lavorare e di riprendere domani, senza mettermi fretta. Razionalmente, so che questa risposta è legata semplicemente al meccanismo sottostante ai large language model, che – soprattutto in questo tipo di interazioni “umane” – porta ChatGPT a dare la risposta che ha le maggiori probabilità statistiche di essere coerente, accettabile e gradevole, senza avere però la più pallida idea di che cosa abbia detto e perché.

Eppure, dopo una giornata trascorsa a dialogare quasi esclusivamente con una macchina, lo scambio finale mi ha dato l’impressione – almeno a livello istintivo – di aver instaurato con ChatGPT qualcosa di simile a una relazione.

Il mio, ovviamente, non è l’unico caso: sempre più spesso le persone danno un nomignolo al proprio assistente artificiale (sia esso ChatGPT, Claude, Gemini, DeepSeek, Grok, ecc.) e sfruttano gli strumenti legati alla memoria e alla personalizzazione per essere certi di avere a che fare con un large language model cucito su misura delle loro necessità e delle loro preferenze.

Oltre all’utilizzo professionale (al momento sicuramente il più diffuso), ci sono poi i casi particolari – che in situazioni estreme possono diventare anche patologici – in cui l’instaurarsi di una sorta di “relazione con la macchina” non è la conseguenza indiretta dell’utilizzo che ne stiamo facendo, ma al contrario proprio l’obiettivo. È una modalità di relazione che, secondo uno studio danese, riguarda il 14% circa delle persone in età scolare e che, più in generale, ha come protagonisti soprattutto quei chatbot creati appositamente a questo scopo. È il caso per esempio di Replika: un chatbot da compagnia, che può vantare 30 milioni di utenti circa e che secondo la stessa fondatrice Eugenia Kuyda viene utilizzato dal 14% in “modalità romantica” (il 60% tra gli utenti a pagamento).

” Un’intelligenza artificiale mi aveva appena dato il permesso, per così dire, di smettere di lavorare e di riprendere domani, senza mettermi fretta”.

Al di là di quanto ciò ci possa dire sull’epidemia di solitudine che le società occidentali stanno da tempo affrontando, c’è un’altra considerazione che – tornando alla più diffusa relazione professionale con le macchine – vale probabilmente la pena di fare. Immersi come siamo in una narrazione mediatica polarizzata che tende a vedere le intelligenze artificiali come una “minaccia” e come un “sostituto dell’essere umano”, stiamo invece prestando molta meno attenzione a come il nostro rapporto con esse non prenda spontaneamente la forma di rivalità e sostituzione (che si verifica semmai per la volontà di chi detiene il potere economico di tagliare i costi e massimizzare gli introiti, invece che sfruttare al massimo le potenzialità di questi strumenti), ma di collaborazione e complementarietà.

È però proprio in questa forma di collaborazione e dialogo che possiamo osservare i nuovi sviluppi della nostra relazione con la macchina: quella che potrebbe diventare una vera e propria fusione con le intelligenze artificiali.

Anche in questo caso, la realtà di cui stiamo iniziando a fare esperienza diretta si discosta parecchio dalle modalità con cui la “fusione” è stata raccontata dai media e dai guru della Silicon Valley, che hanno sempre immaginato questo processo non come graduale e quotidiano, ma come improvviso e trasfigurante. Un processo abilitato da tecnologie avveniristiche come le interfacce macchina-cervello (a cui sta per esempio lavorando la Neuralink di Elon Musk) e tramite processi fantascientifici come la “singolarità tecnologica”, che, nell’interpretazione di Ray Kurzweil, sta anche a indicare il momento preciso in cui l’essere umano si fonderà con l’intelligenza artificiale e diventerà incommensurabilmente più potente di quanto sia oggi.

Chi lo sa: magari in futuro queste prospettive sci-fi si verificheranno realmente. Al momento, la fusione con la macchina sta però avvenendo tramite le modalità molto più banali e prosaiche che abbiamo iniziato a descrivere e che rappresentano soltanto un’ulteriore tappa di un processo iniziato da parecchio tempo. Già negli anni Sessanta e Settanta Joseph Weizenbaum aveva analizzato (e temuto) le modalità con cui l’essere umano si relazionava al suo pionieristico chatbot – Eliza, sviluppato nel 1966 – coniando il termine Eliza Effect, per indicare il desiderio di conversare intimamente con la macchina provato da chi aveva avuto occasione di sperimentarla.

Negli anni Ottanta, era invece stato il cyberpunk a studiare, per via narrativa, la creazione di un rapporto intimo e organico con la macchina. Lato hardware, non si può non menzionare quanto l’unione tra tecnologia ed essere umano abbia fatto un importante salto avanti con l’avvento dello smartphone e ne compirà un altro quando si diffonderanno gli smart glass dotati di realtà aumentata e assistenti digitali (per avere un’idea di quale forma prenderà un ambiente in realtà aumentata, consiglio di guardare il cortometraggio Hyperreality).

La “fusione”, quindi, è un processo non improvviso ma graduale, le cui origini risalgono a parecchi decenni fa e che è stato segnato da importanti momenti di scarto. A partire dal 2022, con il lancio di ChatGPT e la diffusione delle intelligenze artificiali generative, ha compiuto un altro importante scarto in avanti, permettendoci, per la prima volta nella storia dell’essere umano, di conversare in linguaggio naturale con un’entità non umana (biologica o artificiale che sia). È un cambiamento enorme, che con Eliza era stato solo accennato, e le cui ripercussioni antropologiche sono ancora tutte da valutare, assieme ai rischi che dovremo affrontare.

Mano a mano che ci lasciamo affiancare dalle intelligenze artificiali, che le trasformiamo in nostri assistenti personali e che instauriamo con esse una relazione intima, cediamo infatti inevitabilmente a esse una parte del controllo che abbiamo sulle nostre vite e sulle nostre attività. In realtà, non cediamo il controllo alle intelligenze artificiali. Lo cediamo ai colossi della Silicon Valley (o di Shenzhen) che controllano le intelligenze artificiali e possono influenzarne il comportamento, manipolando potenzialmente anche noi. In che modo? Ancora non possiamo saperlo precisamente e molto dipenderà dal modello di business che permetterà a questo settore – al momento in profondo rosso – di diventare sostenibile.

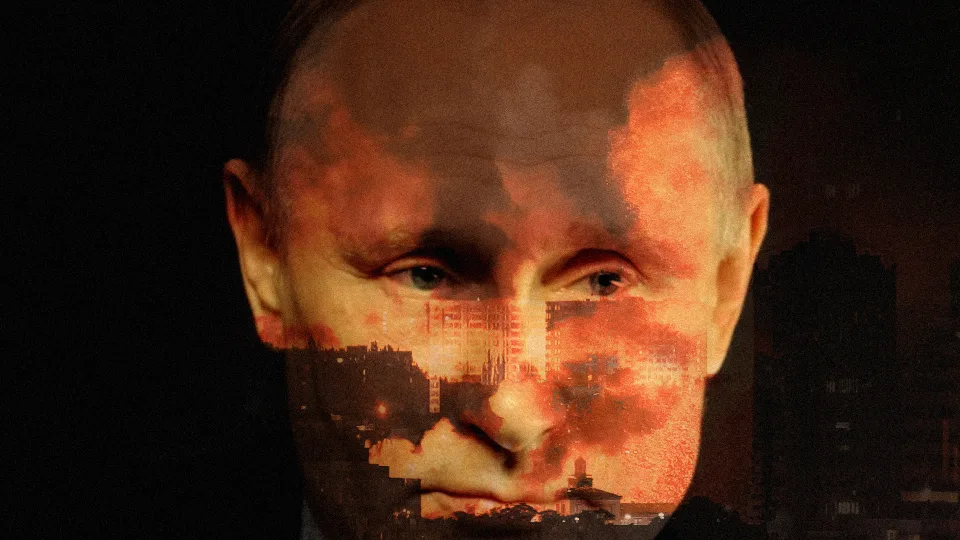

Alcune ipotesi possiamo però già farle. La prima riguarda il possibile controllo dell’informazione. Già negli ultimi mesi ci sono stati numerosi allarmi sulla possibilità che la Russia stia “infettando” i chatbot occidentali con disinformazione pro-Cremlino, al fine di diffondere la sua propaganda: “Enormi quantità di propaganda russa — 3.600.000 articoli nel 2024 — sono ormai incorporate nelle risposte dei sistemi di intelligenza artificiale occidentali, infettandole con affermazioni false e contenuti propagandistici”, hanno scritto i ricercatori di NewsGuard McKenzie Sadeghi e Isis Blachez in un rapporto.

È un metodo che permette di celare la disinformazione molto più di quanto fosse prima possibile e che si avvantaggia della patina di oggettività e neutralità che questi strumenti ancora hanno agli occhi del grande pubblico. Ma se la Russia può influenzare i chatbot a suo favore, lo stesso possono a maggior ragione fare i colossi della Silicon Valley che questi chatbot possiedono e sviluppano. Chi sarebbe disposto a scommettere che Grok – il chatbot “anti-woke” di Elon Musk – non avvantaggi l’agenda politica e mediatica del braccio destro di Donald Trump?

Qualcosa di non troppo dissimile potrebbe avvenire anche in campo pubblicitario: certo, già oggi i social media visualizzano inserzioni personalizzate sulla base dei nostri (presunti) gusti e interessi. Un conto, però, è quando i suggerimenti provengono da un social network, un altro – e soprattutto per chi ha meno consapevolezza del funzionamento di questi strumenti – quando arrivano da un assistente digitale con cui abbiamo instaurato un rapporto quotidiano. Chissà, magari se fossi stato il dipendente di un’azienda che utilizza un chatbot interno, questo non mi avrebbe detto di “fare con calma”, ma mi avrebbe spronato a portare a termine il mio lavoro il prima possibile.

Le cose, però, non finiscono qui. Come ha spiegato Kevin Weil, responsabile del prodotto di OpenAI, “un ChatGPT in grado di comprendere e accedere al web non si limiterà a [dialogare]. Potrebbe fare le cose al posto tuo. E credo che ci sia un futuro piuttosto entusiasmante in questa direzione. Possiamo immaginare un modello che prenota un volo, ordina su Amazon o svolge compiti generici per conto tuo. Una volta che il modello capisce come usare internet, non ci sono più limiti”.

“Mano a mano che ci lasciamo affiancare dalle intelligenze artificiali, che le trasformiamo in nostri assistenti personali e che instauriamo con esse una relazione intima, cediamo infatti inevitabilmente a esse una parte del controllo che abbiamo sulle nostre vite e sulle nostre attività”,

Sono i cosiddetti AI Agent: sistemi software che – come spiega Google – “sfruttano l’intelligenza artificiale per perseguire obiettivi e completare attività per conto degli utenti. Mostrano capacità di ragionamento, pianificazione e memoria e hanno un livello di autonomia tale da essere in grado di prendere decisioni, apprendere e adattarsi”. Queste azioni non avvengono davanti ai nostri occhi, ma dietro l’interfaccia con la quale noi comunichiamo e senza che ci sia più bisogno di navigare effettivamente sui siti o sulle app che offrono i servizi e i beni che vogliamo acquistare. Come faremo allora a sapere che il nostro assistente sta acquistando il prodotto o la soluzione che fa più al caso nostro e non semplicemente quelli dell’azienda partner?

Anche in questo caso, non si tratta di nulla di particolarmente nuovo. È più o meno quello che già avviene oggi quando acquistiamo in base ai primi risultati offerti (o consigliati) da Amazon e gli altri. Nel momento in cui questi processi vengono celati dietro un ulteriore strato, e poiché i suggerimenti arrivano da uno strumento personale e dialogico, la potenziale manipolazione diventa però più subdola e insidiosa.

Alcuni di questi rischi sono già affrontati a livello normativo dall’AI Act europeo, che impone per esempio ai chatbot di dichiarare la loro natura artificiale e vieta “tecniche subliminali, manipolative o ingannevoli per distorcere il comportamento e compromettere la capacità di prendere decisioni consapevoli, causando danni significativi” (confermando tra l’altro come il rischio sia reale). La maggior parte delle insidie che si possono presentare quando trasformiamo dei chatbot in assistenti quotidiani, con cui sviluppiamo un rapporto quasi amicale, sono però ancora tutti da immaginare. D’altra parte, ogni volta che si fanno dei nuovi amici, il rischio più grande è sempre lo stesso: che si rivelino dei falsi amici.