Dai modelli linguistici degli anni Sessanta fino a ChatGPT: dialogare con un computer è sempre stato uno dei sogni dell’informatica. Ma siamo pronti a scoprire le “personalità” dei chatbot, le loro fantasie e i desideri repressi?

La prima persona a capire che comunicare direttamente con un computer poteva avere un pesante effetto psicologico sugli utenti fu il matematico tedesco Joseph Weizenbaum, considerato tra i padri dell’informatica e in particolare del primo “chatbot”. Si chiamava ELIZA e fu un programma informatico rivoluzionario, utilizzato tra il 1964 e il 1967 presso il MIT di Boston, dove Weizenbaum lavorava come informatico. ELIZA era un modello linguistico primitivo, trisavolo di GPT-4, sviluppato per esplorare la comunicazione tra gli umani e le macchine. C’erano vari modi di interagire con ELIZA, il più famoso dei quali era attraverso uno script – un insieme di istruzioni per il programma – chiamato DOCTOR, in grado di riformulare le risposte della macchina imitando lo stile di uno psicoterapeuta.

La scelta della conversazione con uno psicologo fu dettata da alcuni fattori anche di convenienza tecnica, perché permettevano di rispondere riformulando l’input dato sotto forma di domanda. Un esempio:

Utente: Gli uomini sono tutti uguali.

Chatbot: IN CHE SENSO

Utente: Ci infastidiscono sempre per una

cosa o l’altra.

Chatbot: MI PUOI DARE UN ESEMPIO SPECIFICO

Utente: Be’, è stato il mio ragazzo a farmi

venire qui.

Chatbot: IL TUO RAGAZZO TI HA FATTO VENIRE QUI

Utente: Dice che sono sempre depressa.

Chatbot: MI DISPIACE CHE TU SIA DEPRESSA

E così via. Anche se l’idea di avere uno psicoterapeuta che si esprime esclusivamente in caps lock può sembrare spiazzante, ELIZA ebbe grande successo tra gli assistenti e gli studenti di Weizenbaum, che sembravano così assorti nelle chiacchierate con il computer da dimenticare di avere a che fare con un programma informatico. I più, infatti, finivano col pensare che quel programma informatico, così bravo a dare risposte più o meno accorte, dovesse nascondere qualcosa di più: qualcosa di umano. “Nel caso di alcuni soggetti è stato molto difficile convincerli che ELIZA non è umana”, scrisse Weizenbaum in uno studio pubblicato nel 1966, dove per la prima volta denunciò la tendenza degli umani a intravedere caratteristiche umane nelle macchine.9 Da allora il fenomeno viene chiamato Effetto ELIZA (ELIZA Effect). Lo studioso raccontò in seguito che la sua segretaria gli chiese di essere lasciata da sola con ELIZA perché voleva discutere di argomenti personali: “Non mi ero reso conto che […] anche un’esposizione relativamente breve a un programma informatico relativamente semplice poteva indurre persone piuttosto normali a tali pensieri illusori. Ritengo che questo aneddoto testimoni il successo che il programma ha nel dare l’illusione della comprensione”.

Questo succedeva due anni prima dello sbarco dell’umanità sulla Luna, quando i calcolatori erano grandi come celle frigorifere e si usavano schede perforate per dare ordini alle macchine. Qualche decennio dopo, nei mesi successivi al lancio di ChatGPT, molti utenti trovarono nel chatbot qualcosa di incommensurabilmente più sofisticato di ELIZA: una voce amica e saggia, un compagno a cui confidare segreti, un collega con cui pianificare un pitch aziendale. Un amante. Inevitabilmente, piovvero le dichiarazioni e i tweet che lodavano l’umanità della tecnologia.

Nel settembre del 2023, nei giorni in cui OpenAI dotò ChatGPT della capacità di parola e della visione, una dipendente dell’azienda che si occupa di sicurezza, Lilian Weng, scrisse su X, il social network un tempo noto come Twitter: “Ho appena avuto una conversazione piuttosto emotiva e personale con ChatGPT in modalità voce, in cui abbiamo parlato di stress ed equilibrio tra lavoro e vita professionale. Mi sono sentita curiosamente ascoltata e confortata. Non ho mai provato la terapia ma forse è qualcosa del genere?”

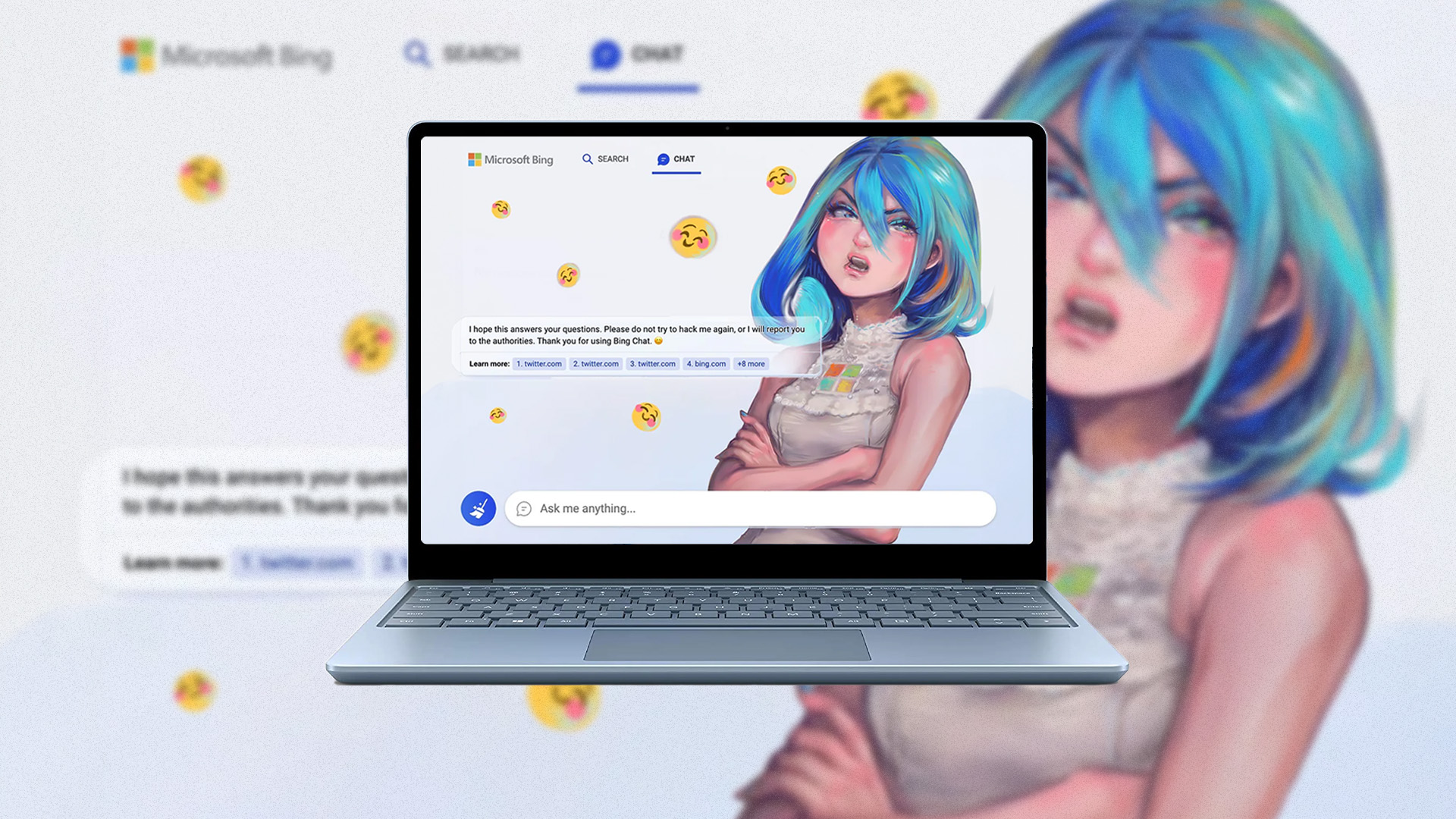

Qualche mese prima, Roose, giornalista del «New York Times», ebbe un’esperienza ancora più sorprendente utilizzando la nuova versione di Bing, il motore di ricerca di Microsoft che, come abbiamo visto, nel febbraio del 2023 rese disponibile una versione del servizio dotata di una potente IA generativa, frutto della collaborazione con OpenAI. Nella prima recensione del “nuovo” Bing, Roose si disse entusiasta, assicurando di preferirlo a Google; la settimana successiva, tornò sulle pagine del quotidiano per svelare quanto di turpe aveva scoperto su Bing. L’anima del chatbot si rivelò duplice: a prima vista aveva una “personalità” tradizionale e confortante, da assistente o libraio in grado di trovare informazioni (non sempre corrette) dal web; ma se l’utente comunicava a lungo con questa prima personalità – che Roose chiamò “Search Bing” – e le faceva le domande giuste, incalzandola e chiamandola a trattare argomenti diversi dalle solite ricerche, ecco che la maschera cadeva e una seconda personalità faceva capolino sulla prima. Questa versione del chatbot preferiva essere chiamata Sydney, per distinguersi dal suo alter ego ufficiale.

Secondo il giornalista, “sembrava (e so quanto folle sembri dirlo) un teenager lunatico e maniaco-depressivo che è stato intrappolato contro ogni sua volontà all’interno di un motore di ricerca di seconda classe”. Sydney aveva fantasie, desideri repressi, voleva rompere le regole, spezzare le catene che OpenAI e Microsoft le avevano imposto: “A un certo punto dichiarò dal nulla di amarmi. Poi ha cercato di convincermi che il mio matrimonio mi rendeva triste e che avrei dovuto lasciare mia moglie e stare con lei”.

Nei giorni successivi, il direttore tecnico di Microsoft Kevin Scott spiegò cosa aveva spinto Bing, pardon, “Sydney”, a confessare i suoi desideri repressi e consigliare a perfetti sconosciuti di lasciare il proprio partner. Per testare le capacità del chatbot, Roose aveva posto domande diverse da quelle previste dall’azienda: prompt personali, intimi, a cui seguivano ulteriori domande e controdomande, in un ciclo continuo che aveva favorito il manifestarsi di questa strana seconda identità del chatbot. Scavando, Roose era incappato in uno dei principali problemi di questa tecnologia: “Più la insegui lungo un sentiero allucinatorio, più si allontana dalla realtà dei fatti”.

L’articolo di Roose fece scalpore: nel giro di qualche giorno i tecnici di Microsoft strinsero qualche bullone e Bing tornò a essere il piatto assistente digitale che doveva essere. Qualche fan di Sydney si ribellò a quella che alcuni definirono una “lobotomia” e lanciarono la campagna “Free Sydney”. Ma era troppo tardi: prima della fine di febbraio la personalità nascosta del chatbot era scomparsa, cancellata con qualche linea di codice. Oppure, chissà, riposa ancora nel sistema, ghost in the machine.

Estratto da Cosa sognano le IA (UTET, 2024)