Leonardo Bianchi

“Ciao, sono stato brutalmente ucciso e ti racconto la mia storia”

09 Ottobre 2023

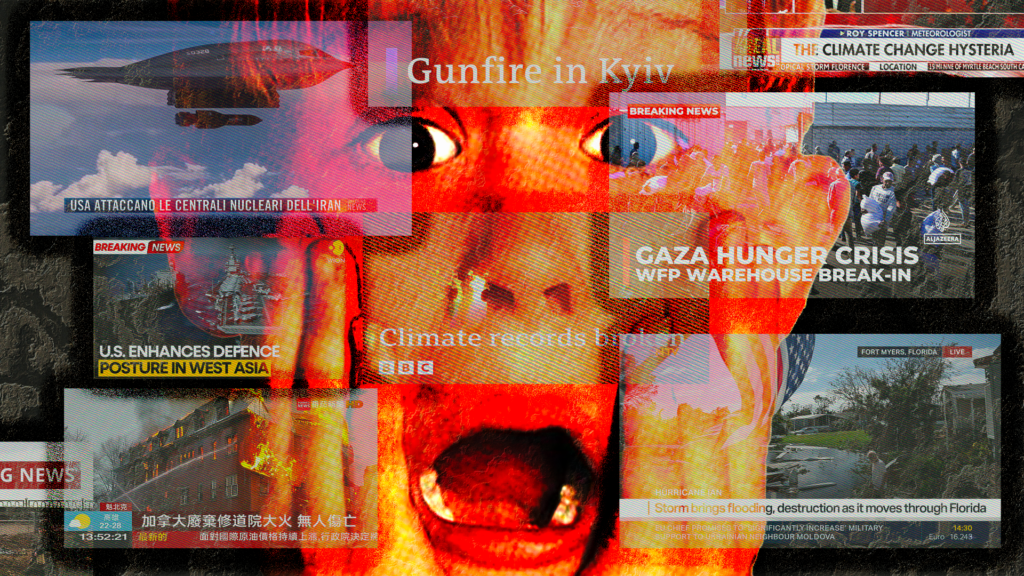

L'ultimo trend su TikToK: le vittime di efferati casi di cronaca nera raccontano la loro storia. Se superficialmente può sembrare solo una nuova e innocua tendenza, in realtà ha ben poco di nuovo e forse nulla di innocuo.

Il video comincia all’interno di quello che sembra essere un forno bianco dentro il quale svetta il mezzo busto di un bambino con una pelle innaturalmente liscia – quasi di porcellana – e degli occhioni luccicanti.

“Sono stato messo in un forno a microonde e sottoposto a un calore intenso dalla mia stessa madre”, dice con voce innaturalmente infantile, “e vi racconto il giorno che non dimenticherò mai, anche se avevo solo 28 giorni”.

Ora, il bambino si mette a raccontare com’è finito lì. Dopo un litigio tra la madre e il compagno, “mi sono trovato in uno spazio buio e stretto, dove faceva caldo e non riuscivo a respirare bene”. Poi si dilunga in dettagli cruenti: “il mio corpicino cominciò a diventare molto caldo, sembrava che stesse friggendo. Avevo segni di bruciature su tutto il corpo. Non ero più vivo”. La sua brevissima esistenza, conclude amaramente, “è stata interrotta proprio dalla persona che avrebbe dovuto amarmi e proteggermi”.

Ovviamente, il bambino che parla non è vero; e pure diversi dettagli non lo sono – a partire dal nome. Nella descrizione viene identificato come “Peris Stallys”, mentre nella realtà è Paris Talley. La storia è abbastanza accurata, ma il genere e il colore della pelle della vittima no: Paris era una bambina nera.

Poco importa, perché i risultati sono eccellenti: il video in questione ha raccolto più di 23mila like e raggiunto più di mezzo milione di visualizzazioni su TikTok.

L’account che l’ha realizzato si chiama Zodiaco del giorno e ha 25mila follower: oltre a occuparsi di segni zodiacali e oroscopi, pubblica video in cui le vittime di cronaca nera vengono “resuscitate” con l’intelligenza artificiale.

Facendo una rapida ricerca nell’hashtag #storiavera, sono decine i profili specializzati in questo tipo di contenuto.

Questi video si assomigliano tutti. Le frasi iniziali d’impatto (“mi hanno trovato in mare senza testa e mani”; “mi hanno torturato e ucciso”; “ho preso sei proiettili alla testa per aver segnato un autogol”), sono volte a catturare l’attenzione degli utenti per farli rimanere oltre i fatidici primi tre secondi.

Le musiche di sottofondo sono da film horror, dominate da archi e percussioni. Il linguaggio è pieno di calchi dall’inglese o refusi, e talvolta ricorda quello dei chatbot alla ChatGPT.

Le ricostruzioni abbondano di particolari sanguinolenti: in un video sull’omicidio di Luca Varani, la vittima racconta come gli assassini Marco Prato e Manuel Foffo abbiano “infierito su di me con una crudeltà incomprensibile, mi hanno lasciato morire dissanguato mentre il mio corpo si avvicinava al limite della sopportazione”.

Spesso questi video diventano virali. Uno dedicato a Mahmoud Sayed Mohamed Abdalla – il barbiere 18enne ucciso a Genova nel luglio del 2023 – ha raggiunto quasi tre milioni e mezzo di visualizzazioni; un altro, sul calciatore colombiano Andrés Escobar, è arrivato a due milioni e mezzo. E poi ci sono Aldo Moro che racconta di come la sua morte abbia “lasciato un segno indelebile nella storia italiana”, e Giuseppe Di Matteo che – vestito da chierichetto – spiega cosa si prova a essere sciolti nell’acido da Cosa nostra.

Insomma: repliche digitali di persone ammazzate che raccontano la loro fine. Questo è quello a cui milioni di utenti italiani di TikTok sono sottoposti ogni giorno; utenti che, tuttavia, sembrano apprezzare questi contenuti al punto da richiederne di nuovi – su altri casi di cronaca – nei commenti.

Ma come si è sviluppato questo trend? Anzitutto, il fenomeno non è nato in Italia ma negli Stati Uniti.

Tra i primi a parlarne c’è stata la rivista «Rolling Stone»: la giornalista Ej Dickson l’ha definito “un incubo a occhi aperti” potenziato dall’algoritmo di TikTok, che sfrutta la vita – e l’immagine – di persone uccise per racimolare like e visualizzazioni.

“Insomma: repliche digitali di persone ammazzate che raccontano la loro fine. Questo è quello a cui milioni di utenti italiani di TikTok sono sottoposti ogni giorno”.

Al tempo stesso, annota un altro articolo sul tema pubblicato sulla rivista «Document», il formato fa leva sulla crescente fascinazione per il genere true crime. Negli Stati Uniti, secondo un sondaggio condotto da YouGov, circa la metà del campione intervistato dice di consumare contenuti legati alla cronaca nera, mentre un terzo lo fa più di una volta a settimana.

In Italia non esistono rilevazioni di questo genere. Sappiamo però, grazie a una ricerca dell’Osservatorio di Pavia del 2017, che i telegiornali italiani hanno dedicato il doppio del tempo alle notizie di cronaca nera rispetto a quelli degli altri paesi europei; e che i media in generale si occupano moltissimo di crimini violenti, specialmente nei periodi elettorali.

Al di là della televisione, che il genere è molto apprezzato lo si può capire dal successo di canali tematici su YouTube e da alcuni podcast, come Veleno e Indagini.

L’idea che sta alla base di questi video non è nuova.

A dirmelo sono Antonio Paolacci e Paola Ronco, autori di romanzi gialli e del saggio Tu uccidi (Effequ): “Viene in mente il romanzo del 2002 Amabili resti di Alice Sebold, dove la voce narrante è quella di una ragazzina che è stata stuprata e uccisa e che racconta la propria storia al passato, dall’aldilà”.

Più in generale, è la narrativa true crime ad “aver dato voce ai protagonisti di un crimine realmente avvenuto, a cominciare da A sangue freddo di Truman Capote, che ha fondato il genere”.

L’elemento di novità sta nell’aspetto tecnologico: in questi video sono le vittime a parlare. Valentina Tanni – esperta di culture digitali e autrice di Exit Reality (Nero Editions) – pone l’attenzione sull’evoluzione esponenziale dei tool basati sull’intelligenza artificiale e sulla loro sempre maggiore accessibilità.

Software come Stable Diffusion, VEED, SadTalker, D-ID (tra i tanti) “permettono infatti, con costi e tempi vicini allo zero, di produrre contenuti originali su qualsiasi cosa”, spiega Tanni.

In particolare, TikTok è pieno di “contenuti generati con tecniche di deepfake” (cioè di falsificazione di video e immagini) che talvolta raggiungono una qualità impressionante – basti pensare al finto Tom Cruise, interpretato dall’attore Miles Fisher. In questo caso, “il livello di verosimiglianza è fondamentale, perché si vuole impressionare, se non ingannare, chi guarda”.

In altri casi, come quelli dei deepfake di cronaca nera, la qualità del video non conta così tanto: l’obiettivo è quello di diventare virali intercettando la “curiosità che il pubblico nutre per questo genere di storie”.

La persona che gestisce l’account La storia vive ha “iniziato per hobby”, raggiungendo rapidamente 88mila follower prima di essere sospeso dalla piattaforma (ora ha un secondo canale da oltre 16mila iscritti).

Secondo lui, il successo di pubblico deriva dal fatto che i video ripropongono “storie e vittime che sono dimenticate” in modo coinvolgente.

Ma secondo Paolacci e Ronco, in tutto questo c’è un aspetto paradossale che non si può ignorare: nel momento in cui questa tecnologia “permette di far parlare persone realmente esistite in modo visivamente molto realistico, nella nostra percezione quelle persone diventano di colpo una falsificazione”.

“Vediamo la vittima, la ascoltiamo, ma sappiamo che non è lei a parlare, che quella non è la sua voce, che non ha mai pronunciato quelle parole”, proseguono. “L’effetto è straniante; ‘perturbante’, direbbe un freudiano”.

La scarsa qualità degli script contribuisce non poco alla sensazione di straniamento. Nel video di Mahmoud Sayed Mohamed Abdalla, ad esempio, l’avatar della vittima dice di “essere rimasto senza parole dopo che ho saputo di tutto ciò che è successo dopo la mia morte”, e che “nessun telegiornale ha ancora parlato di me” – cosa assolutamente non vera, visto che il caso è stato ampiamente trattato in televisione.

Quello di Luca Varani si chiude con un grottesco appello da influencer agli spettatori: “guardando indietro mi chiedo il perché. Perché sono stato scelto? Commentate il perché secondo voi”.

Per Valentina Tanni, questi “fantasmi evocati tecnologicamente” che raccontano in prima persona la propria storia innescano il cosiddetto effetto uncanny valley.

L’espressione – traducibile in italiano come “valle perturbante” – è stata coniata nel 1970 dallo studioso giapponese di robotica Masahiro Mori e descrive quella sensazione di disagio mista a repulsione alla vista di un essere dalle fattezze umane, ma che non è del tutto umano.

“Nonostante i rapidissimi progressi in termini di fotorealismo”, precisa Tanni, “la figura umana in questi video risulta sempre innaturale: i movimenti non sono fluidi, lo sguardo è perso nel vuoto. C’è sempre qualcosa che percepiamo come fuori posto, che ci fa provare una sensazione di disagio simile a quella che si prova di fronte ai robot antropomorfi”.

Solo che, per l’appunto, questo trend non ha come protagonisti dei robot: si basa sulle storie di persone esistite veramente che hanno lasciato genitori, sorelle, fratelli e parenti.

Ed è il loro consenso a fare la differenza sia da un punto etico, sia da quello legale.

Nel 2022, ad esempio, è uscito un video musicale in cui compariva il rapper Depzman (nome d’arte di Joshua Emmanuel Ribera), accoltellato a morte da un coetaneo nove anni prima fuori da un locale di Birmingham.

La “resurrezione” di Depzman con l’intelligenza artificiale era stata voluta dalla madre Alison Cope, come parte di una campagna di sensibilizzazione sulla violenza giovanile e la piaga delle armi da taglio nel Regno Unito. A volte, sono proprio i parenti della vittima a volere i deepfake. La persona che gestisce l’account La storia vive spiega che “il 70% dei contenuti del canale è richiesto da familiari” per denunciare “ingiustizie nei processi” o porre l’attenzione su “casi ancora irrisolti”.

Ma la maggior parte dei creator di questi video non coinvolge i familiari, né si preoccupa di ottenere il loro consenso. Al massimo, si specifica nella didascalia di non usare le foto dei defunti per “rispetto della privacy della famiglia”, oppure ci si limita a cambiare qualche dettaglio biografico.

I creator riescono così a sfruttare un’area grigia del diritto e delle stesse linee guida di TikTok. In teoria, infatti, la piattaforma richiederebbe l’etichettatura dei contenuti generati dall’intelligenza artificiale; nella pratica, molti dei video citati in precedenza non la possiedono.

I contenuti che riproducono le sembianze di un personaggio pubblico o privato sarebbero poi vietati. Tuttavia, tali contenuti spesso non vengono rimossi; e pure se lo sono, altri account simili li ricaricano o li rifanno da zero – proprio perché il genere è facilmente replicabile e molto fruttuoso.

Negli Stati Uniti, sottolinea l’articolo di «Document», la regolamentazione federale dei deepfake si sta rivelando molto più difficile del previsto, perché bisogna bilanciare il diritto alla privacy con la libertà d’espressione garantita dal primo emendamento. Alcuni stati – come la Virginia, la California e New York – hanno vietato i deepfake a sfondo pornografico. Ad avviso del professore di diritto penale Paul Bleakley, interpellato da «Rolling Stone», sul piano giuridico i deepfake di cronaca nera non sono assimilabili a quelli pornografici.

Al momento, l’unico strumento a disposizione dei familiari delle vittime per ottenere giustizia sarebbe quello di intentare una causa civile – senza alcuna garanzia di successo: non ci sono precedenti in materia.

Per quanto riguarda l’Italia, le norme sono decisamente più stringenti. “Nel diritto italiano l’immagine di una persona è tutelata in maniera molto forte”, mi spiega Giovanni Battista Gallus, avvocato di Array Law e Fellow del Centro Nexa su Internet e Società del Politecnico di Torino.

La legge sul diritto d’autore stabilisce la regola generale del “consenso dei familiari per la pubblicazione del ritratto”, con alcune eccezioni dovute alla notorietà del personaggio. In più, il codice della privacy “estende a determinate condizioni l’esercizio dei diritti degli interessati anche per le persone defunte”.

“Al momento, l’unico strumento a disposizione dei familiari delle vittime per ottenere giustizia sarebbe quello di intentare una causa civile o sporgere una querela per diffamazione – senza alcuna garanzia di successo: non ci sono precedenti in materia”.

In altre parole, dice Gallus, “l’uso di un deepfake che ha le sembianze di un defunto difficilmente può essere lecito, salvo il consenso espresso dei familiari”. E di certo non è giustificato “dal diritto di cronaca o dalla libertà d’informazione, che al massimo consentono la pubblicazione del semplice ritratto, di certo non la sua resurrezione per raccontare la vicenda”.

Nonostante ciò, questo formato si è imposto in brevissimo tempo grazie all’accessibilità dei software di intelligenza artificiale, all’algoritmo di TikTok e soprattutto allo stile con cui sono girati.

In questi video le vittime si comportano come un qualsiasi creator sulla piattaforma. Irrompono con i loro volti nel rullo continuo dei “Per te” – la pagina personalizzata in base agli interessi degli utenti –, cercando di catturare l’attenzione con un contenuto davvero esclusivo: la propria morte.

E lo fanno ricorrendo alle più consumate strategie di spettacolarizzazione mediatica della cronaca nera: una certa morbosità, che porta a indugiare su particolari macabri, lo sfruttamento del dolore delle vittime e il racconto serializzato dei crimini (alcuni casi sono spezzati in più video).

Ma le vittime, per l’appunto, sono reali ma non sono vere. E quei video non sono stati realizzati da esseri umani. Certo: qualcuno ha inserito le immagini o scritto i prompt; ma il risultato finale è interamente prodotto da un software.

E questo mette ancora più a disagio, perché non si conoscono appieno le possibilità e i limiti di queste tecnologie.

L’intreccio tra intelligenza artificiale e cronaca nera potrebbe infatti spingersi ben oltre i deepfake su TikTok, arrivando fino al limite estremo della ricostruzione digitale di delitti – magari a pagamento, o su commissione.

Leonardo Bianchi

Leonardo Bianchi è giornalista. È stato news editor di «Vice» . Il suo ultimo libro è Complotti! (minimum fax, 2021).

newsletter

Le vite degli altri

Le vite degli altri è una newsletter che racconta di vite che non sono la nostra: vite straordinarie, bizzarre o comunque interessanti.

La scriviamo noi della redazione di Lucy e arriva nella tua mail la domenica, prima di pranzo o dopo il secondo caffè – dipende dalle tue abitudini.

Contenuti correlati