Quando i primi prototipi di chatbot sono stati rilasciati, gli psicologi sembravano tra le professioni più al sicuro: le interazioni erano goffe e farraginose - e nessuno sembrava prendere sul serio quegli scambi. Con le nuove AI tutto è cambiato e sempre più persone, per vantaggi di tempo ed economia, si rivolgono a ChatGPT per parlarle dei propri problemi. Ma è un bene?

Recentemente mi sono imbattuto in un meme che recitava I told ChatGPT about you, una variazione del più noto I told my therapist about you.

In effetti stiamo affidando ormai all’intelligenza artificiale porzioni sempre più ampie della nostra vita quotidiana e la salute mentale non fa eccezione: in parte perché i nostri pensieri ci accompagnano ovunque, in parte perché è un tema onnipresente sui social.

I chatbot come ChatGPT sono costruiti su large language models, modelli statistici che analizzano vasti insiemi di dati testuali e generano risposte calcolando quali parole è più probabile appaiano in una certa sequenza. Fino a pochi anni fa restituivano risposte goffe e ripetitive. Sembrava allora scontato che professioni sanitarie come la medicina o la psicologia sarebbero rimaste tra le meno sostituibili dall’AI. Oggi, invece, in tanti, per lo più giovani, sembrano rivolgersi ai chatbot per ricevere compagnia, consigli relazionali, quesiti sentimentali, quasi come fossero degli psicoterapeuti fai da te. Su Reddit e TikTok proliferano i post in cui gli utenti sono grati a ChatGPT per essergli stata vicino, che lo descrivono come un safe space, migliore del loro psicoterapeuta, con cui intrattenere lunghe conversazioni notturne.

Non mancano del resto i chatbot progettati esplicitamente per offrire supporto emotivo. Tra quelli basati su ChatGPT troviamo TherapyAI, descritto come “un consulente empatico nell’ambito della salute mentale, che offre ascolto compassionevole, orientamento personalizzato e riflessioni sui modelli comportamentali”, oppure Therapist GPT, “progettato per offrire conforto, consigli e supporto terapeutico a chi è in cerca di un orientamento per il benessere mentale.” Li ho testati entrambi chiedendo loro di aiutarmi con problemi di ansia. Entrambi hanno adottato un tono compassionevole: “I’m here for you”, mi ha scritto il primo, mentre il secondo è andato oltre, suggerendomi alcune tecniche cognitivo-comportamentali per gestire la suddetta ansia.

In alcuni post sull’account Instagram di OpenAI, l’azienda dietro ChatGPT, vengono mostrati proprio esempi di conversazioni tra utenti e il chatbot incentrati su temi personali o relazionali. Un utente gli chiede: “Come faccio a sapere se piaccio alla mia crush?”. In un altro post, un utente condivide con il chatbot lo screenshot di una conversazione, chiedendogli se l’interlocutore gli stesse facendo gaslighting. Il chatbot risponde che sì, sembra proprio gaslighting. Nel post, OpenAI ci invita a scrivere a ChatGPT per un sanity check.

Questo fenomeno si inserisce in un contesto più ampio, fatto di servizi digitali dedicati al benessere psicologico: piattaforme che mettono in contatto psicoterapeuti e pazienti, app di self-help, contenuti motivazionali su TikTok e Instagram. Insomma, se da ogni lato di internet ci viene costantemente ripetuto di prenderci cura della nostra mental health o, almeno, sembra che ne abbiamo la possibilità a portata, cosa comporta davvero affidare la propria salute mentale a un’AI?

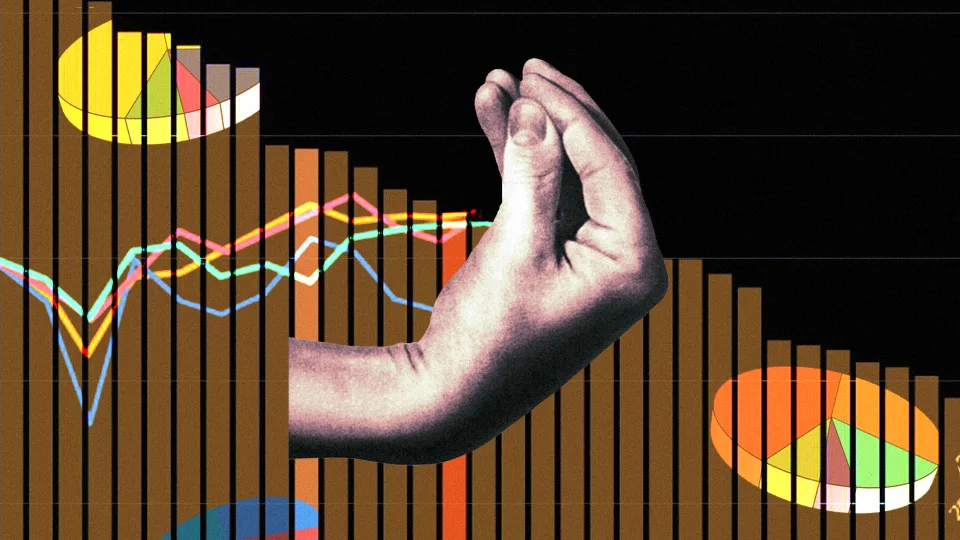

In termini di accessibilità, l’AI rimuove parecchi ostacoli al trattamento: il costo, stigma sociale, disponibilità oraria del terapeuta. La versione più esosa di ChatGPT costa circa 200 dollari al mese, meno di molti psicoterapeuti. La vasta conoscenza teorica con cui è stato allenato ChatGPT e la sua capacità di accedere a informazioni aggiornate potrebbero fornire poi supporto di qualità superiore rispetto a professionisti con formazione limitata o obsoleta. (Con decine di migliaia di psicologi attivi in Italia, sarebbe ingenuo pensare che tutti abbiano la stessa competenza.) In uno studio recente è stato chiesto a 63 psicoterapeuti di valutare delle trascrizioni di sedute condotte tra esseri umani, o tra esseri umani e AI. Non solo non erano in grado di distinguerle, ma hanno giudicato l’AI come mediamente superiore.

Le persone con cui ho parlato che usano ChatGPT per affrontare questioni personali mi sono sembrate piuttosto entusiaste. C’è chi lo fa con leggerezza, come Ilaria, che lo ha istruito a interpretarle i sogni come se fosse uno psicoanalista junghiano: “Prima cercavo i significati su internet, questo è solo un modo più veloce e divertente.”

Enrico mi spiega che trova in ChatGPT uno strumento utile nei momenti di instabilità emotiva, legati all’ADHD e a un possibile autismo. Ne apprezza la disponibilità costante, il costo zero, il tono rassicurante, la capacità di dare consigli pratici, “se non altro perché pesca da un database infinito”.

Alessio mi racconta che chiede a ChatGPT di analizzare alcuni suoi tratti di personalità, commentare come si è comportato in una certa situazione, dargli indicazioni su come interagire con gli altri. “Se ho dei tratti un po’ particolari, ossessioni, gli faccio analizzare anche quelli, così mi tranquillizzo.” Aggiunge: “Il vantaggio è che ha un livello di empatia che gli esseri umani non hanno. Qualsiasi terapeuta ha dei bias legati al proprio vissuto, magari è distratto, poco presente. L’AI, invece, non giudica, è sempre attenta. Per me dimostra una grande forma di empatia.”

L’idea che un algoritmo possa mostrare empatia è interessante – di fatto, si tratta di una simulazione. Ma non è, in fondo, quello che fanno anche gli psicoterapeuti, che vengono pagati per ascoltarci e dimostrare empatia nei nostri confronti, talvolta fingendo di provarne?

Come ha spiegato a «The Free Press» Eugenia Kuyda, la fondatrice di Replika, un chatbot da compagnia con circa 30 milioni di utenti, “Il problema è che la maggior parte di questi prodotti sono stati costruiti da ingegneri, informatici, matematici. Non sono molto bravi a capire le persone, le emozioni”. Kuyda sottolinea quindi un limite strutturale alla base di molti chatbot come ChatGPT, che non nascono con un’intenzione terapeutica, anche se poi finiscono per essere usati in quel modo. Replika invece si ispira in parte alla psicoterapia umanistica di Carl Rogers, secondo cui il terapeuta aiuta il paziente a capirsi meglio ripetendo ciò che dice, spesso sotto forma di domanda.

“In termini di accessibilità, l’AI rimuove parecchi ostacoli al trattamento: il costo, stigma sociale, disponibilità oraria del terapeuta. La versione più esosa di ChatGPT costa circa 200 dollari al mese, meno di molti psicoterapeuti”.

Mi sembra coerente con l’esperienza di Francesca, che si è rivolta a ChatGPT in un momento di fragilità. “Avevo bisogno di una parola di conforto, da qualcuno (o qualcosa) che non potesse giudicarmi.” Sfogarsi l’ha fatta stare meglio, anche se le risposte ricevute le sono sembrate piuttosto semplici e generiche, composte per lo più da frasi di circostanza e riformulazioni di quello che lei stessa aveva scritto (“dev’essere dura per te”).

Chi usa regolarmente l’AI sembra apprezzare di poter parlare senza sentirsi un peso per gli altri. Come si legge ancora su «The Free Press », uno dei vantaggi percepiti dei chatbot è proprio la loro prevedibilità e assenza di giudizio. Il loro successo, forse, non sta in ciò che li rende simili agli esseri umani, ma in ciò che li distingue.

Esistono però diversi limiti. Una delle preoccupazioni principali riguarda l’affidabilità dell’AI. Anche se a volte dà risposte argute e sorprendenti, è anche vero che ChatGPT può commettere errori in semplici calcoli, riportare date sbagliate, inventarsi riferimenti bibliografici, visto che per sua natura deve sempre dare delle risposte. Come possiamo fidarci delle sue risposte su questioni complesse e delicate come la nostra salute mentale? Ciò solleva poi una questione interessante anche rispetto alla psicoterapia: quanti psicoterapeuti, di fronte allo smarrimento del paziente, si permettono di riconoscere uno scacco, di non sapere e di non poter rispondere?

Un altro rischio è la sua tendenza a essere eccessivamente compiacente: per soddisfare l’utente e trattenerlo nella conversazione il più possibile, l’AI finisce spesso per validarne ogni affermazione, anche quando sarebbe necessaria una risposta critica. Lo si intuisce da casi come quello discusso in un post su Reddit, dove vari utenti raccontano con orgoglio di essersi fatti assegnare da ChatGPT quozienti intellettivi ben al di sopra della media – una situazione statisticamente impossibile, che mette in dubbio l’attendibilità delle sue “valutazioni psicologiche”.

Enrico riconosce questo limite: “Quando vado dalla mia psicologa, so già che non mi sentirò dire quello che voglio sentirmi dire. Con ChatGPT è il contrario.” Mi propone una metafora che trovo piuttosto sensata: “l’AI è la capsula di Imodium che torna comoda per evitare incidenti intestinali. La psicoterapia è i test per rilevare le intolleranze, la dieta specifica per prevenirli.”

Certo, è possibile istruire l’AI a non essere sempre accondiscendente, e a metterci più spesso in discussione. “L’ho allenato a non darmi sempre ragione, a non allucinare risposte”, mi spiega ancora Alessio. Anche alcuni psicoterapeuti sui social suggeriscono strategie per ottenere risposte più utili: ad esempio, indicando all’AI di validare le nostre emozioni senza per forza essere d’accordo, di metterci di fronte a domande stimolanti, e di aiutarci a esplorare i problemi da diverse prospettive psicologiche, come farebbe uno psicoterapeuta esperto. Sul «New York Times» uno psicoterapeuta di 81 anni racconta di aver provato a usare ChatGPT per questioni emotive e relazionali e di essere rimasto piacevolmente sorpreso dalle sue risposte, compatibili con quelle che lui stesso avrebbe dato ai propri pazienti. L’ha portato a migliorare il suo modo di pensare, capire meglio le persone intorno a sé, essere più preciso con la comunicazione e consapevole dei suoi pattern.

Secondo «Il Post», mentre appunto alcuni psicologi vedono i chatbot come strumenti utili, altri li considerano dannosi. Il consenso sembra essere che attualmente l’AI non è in grado di rimpiazzare il lavoro di uno psicoterapeuta umano e non dovrebbe essere utilizzata con questo obiettivo.

Di fatti, affinché una psicoterapia sia trasformativa, non dovrebbe essere solo un safe space, ma capace di sfidarci e metterci in discussione. In un’epoca in cui siamo fortemente centrati su noi stessi, chiusi nelle nostre echo chambers con un bisogno disperato di conferme, dovremmo essere invece scettici di ogni strumento che rafforza questa focalizzazione su di sé. Diversi studi scientifici confermano proprio che un’eccessiva attenzione su sé stessi è associata a una diminuzione del benessere psicologico e a un aumento di stati emotivi negativi come ansia e depressione.

È questo uno dei rischi più insidiosi dell’avere uno “psicoterapeuta tascabile” sempre disponibile. Possiamo interrompere la conversazione ogni volta che ci mette a disagio, o usarlo ogni volta che siamo presi da pensieri distorti o ossessivi. Penso a chi soffre di ansia o disturbi ossessivo-compulsivi, che sa bene quanto il bisogno di rassicurazioni possa trasformarsi in un’ossessione: se già con Google ci si può perdere in un loop infinito in cerca di risposte, figuriamoci con un chatbot pronto a darci ogni volta conferme in tempi immediati.

D’altra parte, in chi è predisposto a questi comportamenti, l’uso di AI può anche indurre a creare narrative alterate o trovare significati altri che non esistono nella realtà. Un esempio è chi lo usa per interpretare i messaggi dei propri partner o per farsi aiutare a rispondere, come spiegano alcune ragazze a «Il Post», illudendosi poi che l’AI dia risposte imparziali e oggettive, in quanto ente non coinvolto nelle loro vicende. E questa condotta non è così distante, per certi versi, da un certo modello di psicoanalisi classica: incontri ravvicinati e ripetuti più volte alla settimana che rischiano di trasformarsi in una forma strutturata di rimuginio.

“È questo uno dei rischi più insidiosi dell’avere uno “psicoterapeuta tascabile” sempre disponibile. Possiamo interrompere la conversazione ogni volta che ci mette a disagio, o usarlo ogni volta che siamo presi da pensieri distorti o ossessivi”.

Molte persone sono sole e fanno fatica a costruire legami. Questo, almeno, sembra essere questo uno dei motivi principali per cui i giovani vanno in terapia. Alcuni ricercatori che si occupano di solitudine e difficoltà relazionali vedono nei chatbot e in altre soluzioni tecnologiche (realtà virtuale, persino i robot sessuali) un possibile fronte alternativo di compagnia e ascolto per chi non ha nient’altro.

Ma viene da chiedersi se, nei momenti di crisi, abbiamo davvero bisogno di passare ancora più tempo davanti a uno schermo a ossessionarci con noi stessi con la complicità di una macchina progettata per compiacerci e generare profitto. Se ci sentiamo ansiosi, depressi, persi, forse il primo passo non è parlare con un chatbot, ma trovare uno spazio in cui poter essere davvero visti, con tutte le difficoltà e i rischi che questo comporta. Spazio che può essere costituito dalla psicoterapia, o semplicemente da relazioni affettive solide, magari in comunità capaci di includere anche chi si sente ai margini. In ogni caso, è difficile che degli algoritmi progettati nella Silicon Valley possano sostituire il valore di una relazione umana. Per ora.